Tavus 如何使用 Qdrant Edge 创建对话式人工智能

Daniel Azoulai

·2025 年 9 月 12 日

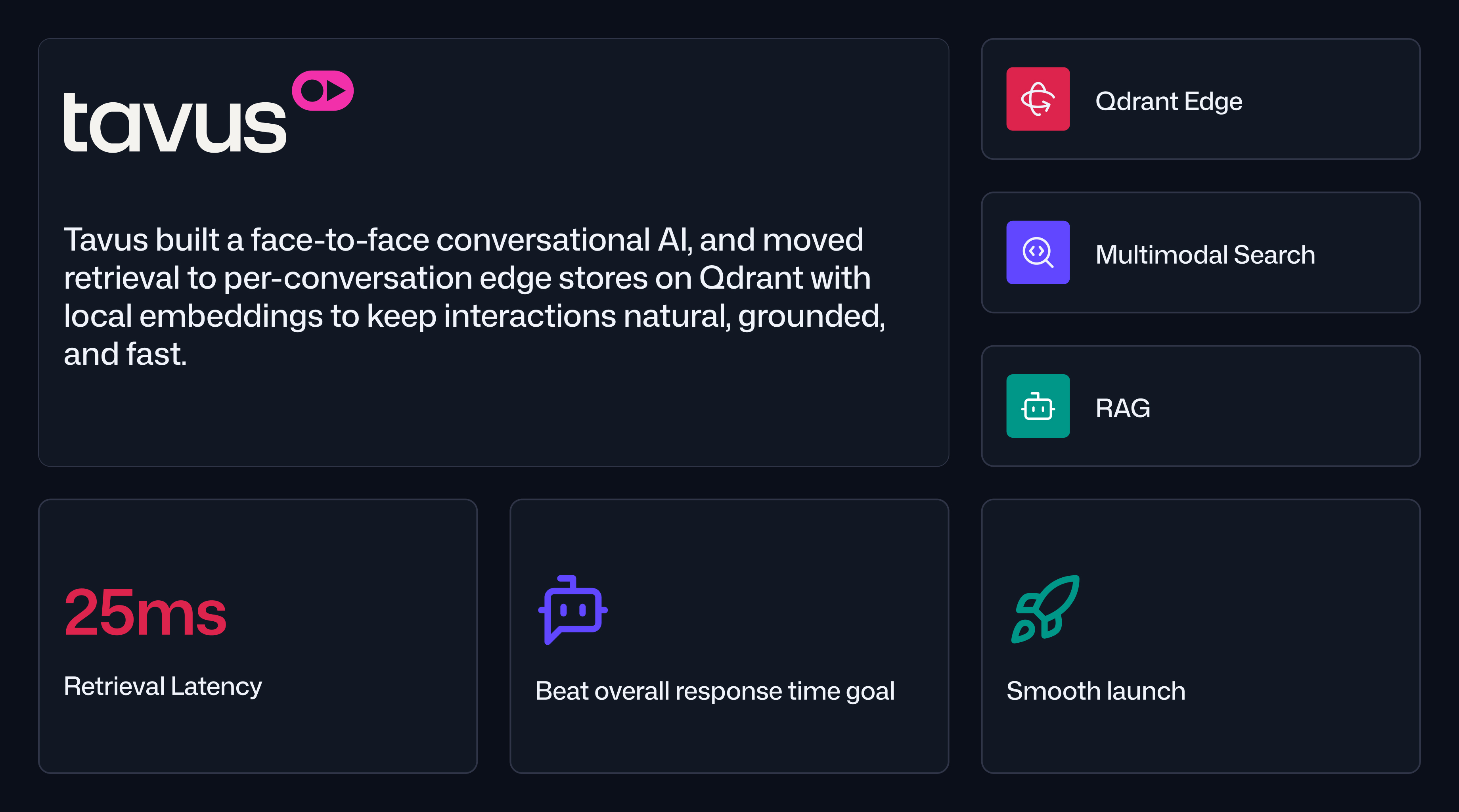

Tavus 如何利用 Qdrant 上的边缘检索实现人类级别的对话式人工智能

Tavus 是一家人机研究实验室,致力于构建 CVI,即对话式视频界面。CVI 提供了一个面对面的人工智能,可以实时读取语气、手势和屏幕上下文,使人类能够以前所未有的方式与强大且功能丰富的人工智能进行交互。团队的北极星目标说起来简单,实现起来却很难:对话应该感觉自然。这意味着要跟踪对话动态,例如话语间的时序、附和和轮流发言,同时将回复基于客户的私人知识。

CVI 的早期迭代侧重于实时对话质量,但未侧重于检索。需要文档依据或召回功能的客户自带 RAG 层,这增加了延迟和不一致性。Tavus 希望将 RAG 内部化,以便能够保证性能、简化入职流程并保持体验的连贯性。

“我阅读了你们的文档,对要做什么有了清晰的认识,然后实施了它,结果它就成功了。从第一天起,简单性和性能就存在了。”

Mert Gerdan,Tavus 机器学习工程师

为什么网络跳数会威胁亚秒级对话流程

人类对话对延迟的容忍度很低。关于对话系统的文献表明,在高度参与的交流中,一个说话者说完到另一个说话者开始的最佳时间约为 200 毫秒。对于 CVI 来说,即使是 500 到 600 毫秒的最佳端到端时间也感觉很紧张,一旦你考虑到理解、规划、文本转语音、面部渲染和流媒体。

添加用于检索的网络跳数可能会将话语间时间推到不可接受的范围。最重要的是,客户需要跨视频、音频和屏幕共享的多模态基础,以及为了安全性和正确性而进行的每对话隔离。检索层必须快速、本地且简单。

每对话边缘向量存储如何消除延迟

Tavus 实施了一个自托管的中心 Qdrant,并为每个对话启动了与对话工作器并置的边缘集合。每个对话都在本地 GPU 上生成嵌入并查询其本地 Qdrant 存储,这消除了检索期间的网络延迟。

平衡速度和质量的设计选择

首要选择是将嵌入和近似最近邻查找都保留在对话运行的节点本地。由于数据从未离开机器,系统避免了序列化和传输延迟,否则这些延迟会占据延迟预算的主导地位。大部分使用都集中在几个集合中,它们根据对话 ID 进行过滤。这使得推理上下文范围变得更容易,并为隐私、审计和生命周期管理创建了一个清晰的边界。

在消除网络跳数后,团队选择了简单而不是调优。他们不需要量化或激进的压缩来争取几毫秒,因此他们专注于检索质量和多模态准确性。这种简单性促成了第二个架构举措:每次话语都进行检索。每个回合都可以触发嵌入和向量搜索,而不会造成可感知的停顿。最后,Tavus 在此基础上分层了推测执行,预测可能的延续,以便代理可以在用户说话时准备回复。这些选择共同产生了一个既自然又不会牺牲正确性的管道。

更快的检索和更流畅的发布带来的业务影响

通过消除网络跳数,Tavus 将边缘检索时间缩短到大约 20 到 25 毫秒。现在,端到端话语间时间在最佳情况下接近 500 到 600 毫秒,留下了足够的空间来增加人工延迟,以处理需要较慢节奏才能感觉更人性化的更深层主题。由于检索在感知延迟方面成本低廉,团队可以为每个回合提供基础,并在对话变得复杂时保持答案准确。

运营状况也得到了改善。在前三周内,Tavus 索引了大约 3 到 350 万个点,每个点代表大约 1500 个字符。发布非常顺利,没有发生任何意外。支持队列保持安静,客户能够将私人知识带入 CVI,而无需搭建自己的 RAG 堆栈。开发人员的速度受益于更小、更清晰的部署模型,该模型更容易理解和扩展。

“我们希望公司体验 CVI 的质量,而无需自己构建 RAG 系统。有了边缘的 Qdrant,检索对用户来说实际上是不可见的。” Mert Gerdan,Tavus 机器学习工程师

团队对架构和速度的理解

Tavus 验证了架构优于微优化。消除网络跳数并将计算与数据并置比通过量化挤出几毫秒带来了更大的延迟收益。通过部署每对话边缘存储,团队可以优化质量和安全性,例如更丰富的多模态功能和更好的轮流发言,而无需牺牲速度。